Verliert man nicht die Inhalte aus dem Blick, wenn man sich so sehr auf die Zahlen konzentriert?

Den Vorwurf hört man immer wieder, wir haben versucht diesen Punkt bewusst zu berücksichtigen. Mein Mitgründer Dominik Wurnig und ich haben uns am Anfang das Ziel gesetzt, dass wir „weniger schlecht” vorhersagen wollen. Uns ist immer wichtig, nicht mit einer Attitüde aufzutreten, dass wir wissen, was passiert. Wir wollen ganz bewusst den Punkt machen, dass man vorsichtig sein muss und wir wollen die Hintergründe der Zahlenspielereien erklären und verdeutlichen, warum das ein kompliziertes Geschäft ist.

Was läuft Ihrer Meinung nach falsch in der Umfrageforschung?

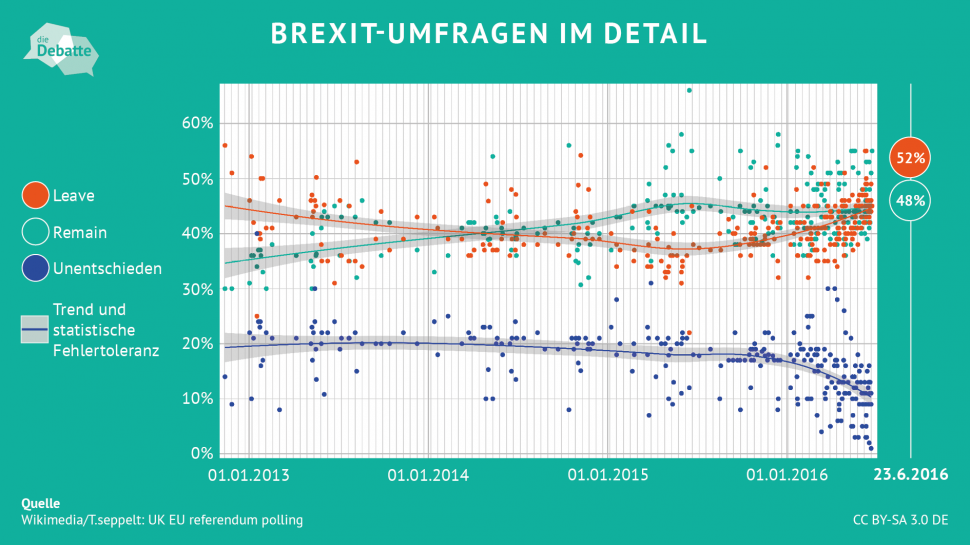

Ehrlich gesagt läuft weniger in der Forschung etwas falsch als in der Präsentation in den Medien und beim Verständnis in der Bevölkerung. Man muss sich einfach klar machen, dass Umfragen nicht auf einen zehntel Prozentpunkt vorhersagen können, wie das Rennen ausgeht. Umfragen können immer nur eine Stichprobe einbeziehen und es ist schwer, Werte beziehungsweise Meinungen von bestimmten Bevölkerungsteilen zu erheben. Das prognostizierte Ergebnis kann immer plus oder minus zwei Prozentpunkte von der Realität abweichen.

Auch die Debatte um die angeblich falschen Vorhersagen bei der Trump-Wahl und beim Brexit wird nicht wirklich richtig geführt. Wissenschaftlich und quantitativ lagen die Umfragewerte in Wirklichkeit nämlich ganz gut. Beide Male war das Problem, dass man sozusagen qualitativ daneben gelegen hat und gesagt hat, dass die andere Seite gewinnt. Bei Clinton und Trump ist es letztendlich so gewesen, dass 70.000 Leute in drei Bundesstaaten die Wahl entschieden haben. Das kann man in Umfragen nie erfassen.

Solche Systeme haben immer auch Grenzen, weil sonst die Befragung viel zu lange dauern oder zu teuer würde. Unterm Strich ist mein Eindruck, dass man den Umfrageinstituten maximal vorwerfen kann zu wenig herauszuarbeiten, wie fehlbar sie sein können. Aber sie treffen auch auf ein Publikum, das ihnen nur allzu gerne glaubt.

Fleisch aus dem Labor

Fleisch aus dem Labor  CO2-Speicherung

CO2-Speicherung  Biodiversität

Biodiversität  Fracking

Fracking  Dürre

Dürre  Pränataldiagnostik

Pränataldiagnostik  Ernährungssicherung

Ernährungssicherung  Energiesicherheit

Energiesicherheit  Quantentechnologien

Quantentechnologien  Kinderarmut

Kinderarmut  Kosten des Klimawandels

Kosten des Klimawandels  Wahlverhalten

Wahlverhalten  Nudging

Nudging  Kryptowährung und Blockchain

Kryptowährung und Blockchain  Genchirurgie

Genchirurgie  Debattenkultur

Debattenkultur  Impfstoffverteilung

Impfstoffverteilung  Corona

Corona  Atomendlager

Atomendlager  Weltraumnutzung

Weltraumnutzung  Drohnen

Drohnen  Gedenkkultur

Gedenkkultur  Medikamentenentwicklung

Medikamentenentwicklung  Organspende

Organspende  Kriminalität

Kriminalität  Krankenhaus

Krankenhaus  Cannabis

Cannabis  Künstliche Intelligenz

Künstliche Intelligenz  Feinstaub

Feinstaub  Geoengineering

Geoengineering  Intelligenz

Intelligenz  Wohnungsmarkt

Wohnungsmarkt  Plastikmüll

Plastikmüll  Digitalisierte Kindheit

Digitalisierte Kindheit  Frieden

Frieden  Meinungsforschung

Meinungsforschung  Alzheimer

Alzheimer  Bienensterben

Bienensterben  E-Zigarette

E-Zigarette  Social Bots

Social Bots  Autonomes Fahren

Autonomes Fahren  Flucht und Migration

Flucht und Migration